[ Topology ]

- vSphere Topology는 아래 첫번째 그림과 같은 구성인데, 여기에 vSAN을 더해 오른쪽 그림과 같이 구성 예정

[ vSAN ]

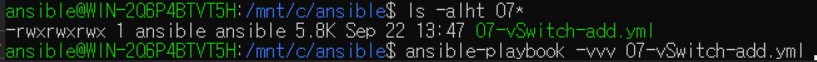

ㅁ Ansible .yml file 생성

ㄴ적용 시킬 .yml file Script 작성

ㄴ Ansible로 .yml file 실행

ㄴ 아래 Network 구성 확인

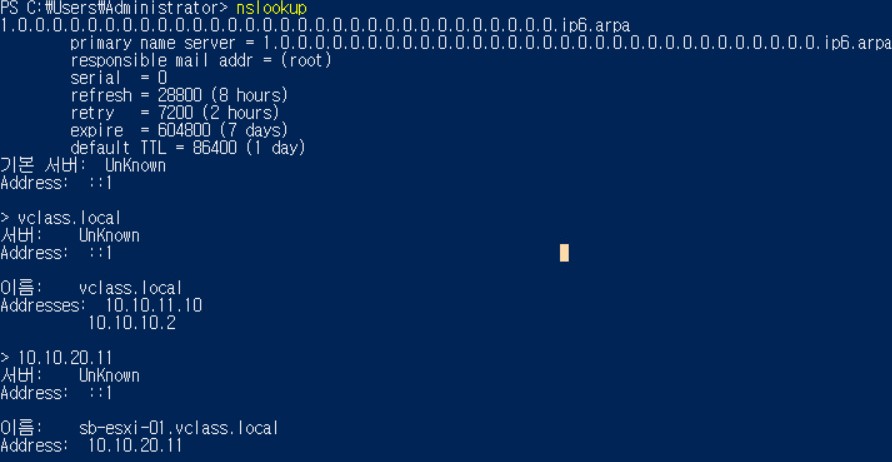

ㄴ DNS host record Script 작성

ㄴ PowerShell 로 해당 Script 실행

> Domain name 정방향 역방향 모두 조회 잘 되는것 확인

ㄴ Host 3 ea 일괄 생성 이기 때문에 아래 그림처럼 'DPG-vSAN' 분산 포트 그룹의 호스트 수 확인

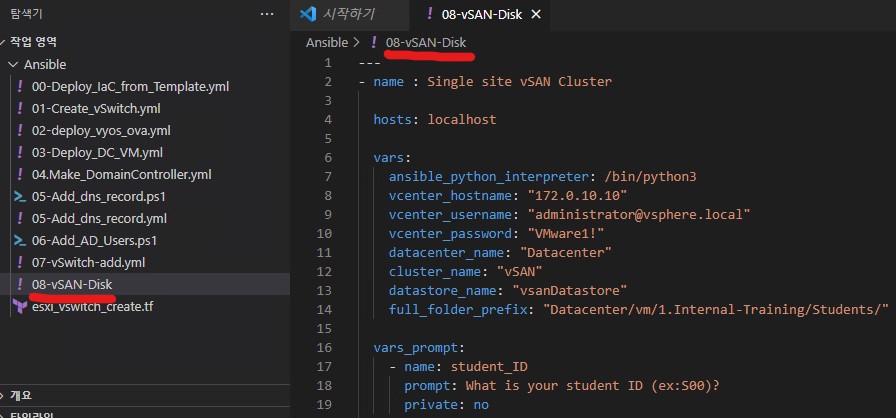

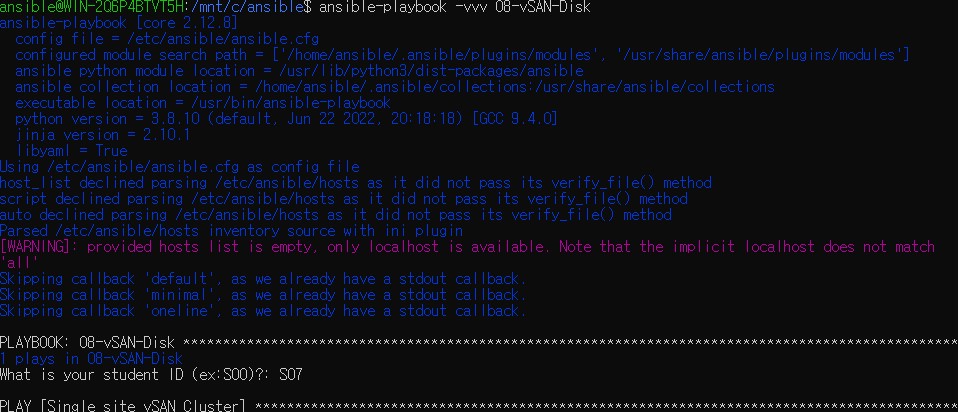

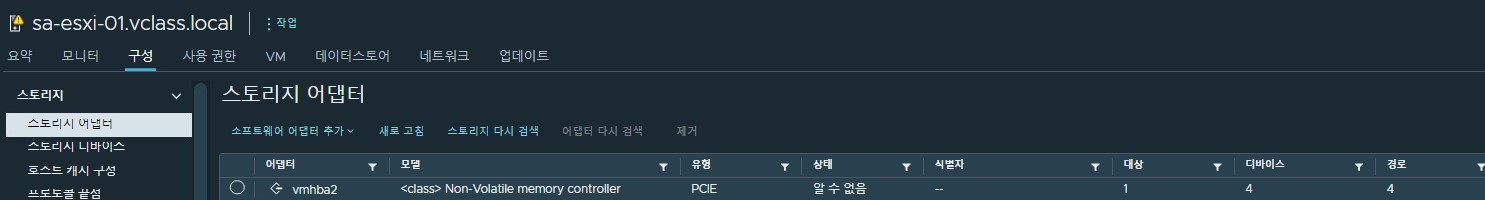

ㄴ vSAN Disk 생성 w. ansible 및 vCenter Server PCIe Device 확인

> 위 Script로 만든 .yml file / Ansible run

> vCenter Server Storage Adapter / Device 확인

* Physical DataCenter에는 Server, Network 장비 별 Rack 이 있는데, Rack 상단엔 항상 ToR Switch (Top of Rack Switch)

이 있어 Rack 에 있는 DB Server의 Fault가 발생 하더라도, Mesh up된 Network 구성으로 Data를 다른 DB Server로 복제해 항상 Failover에 대비를 해둔다

> 공간 효율성(압축 전용) - 똑같은 Data를 두번 세번 쌓을 필요 없이 Network만 연결 되어 있으면 같은 내용인지 확인하는 Process가 있지만 이 작업이 실행되는 동시 CPU, Memory, Disk 가동률이 높아지게되므로 성능이 충분해야 한다

VMware vSAN에서도 Full SSD를 사용 함

> 중복 제거 및 압축

> 전송중 Data 암호화 - 중요 Data는 암호화 되어 유출이 되더라도 해독이 불가하기 때문에 민감 정보를 저장하는 Disk일 때 사용

> RDMA

ㄴ 2 Node vSAN(두 대의 Server만 구성한 형태)

지사에는 사람이 많이 없는경우가 있는데 이런곳에서 사용 하기 적합한 형태

ㄴ HCI mesh compute cluster

남는 자원을 다른곳으로 보내거다 끌어다 사용 할 수 있는 Mode

- Data를 쓰는 방식

'우선 고려할 점은 장애 감내 방법, 운영 방법은 어떻게 할 것 인가'

Mirroring - 이라고 하는데, 한 번만 하는게 아닌 두 번 세 번 계속 쓸 수 있지만, Disk사용에 대한 효율성이 떨어진다

Parity - Raid방식이긴 한데, Server가 여러군데 나누어져 있어 사용하기 때문에 Erase Coding이라고도 한다

Kernel Level Service - Kernel로 Network를 통해 전송하는 방식! VM Disk가 있으면, 저장정책을 Mirroring으로 하게되면 모든 저장정책은 Mirroring 으로 고정되어 Object별 설정은 불가함

VM Level Service - VM으로 만들어서 Data를 만들어 Network를 통해 다른 가상머신 장치로 전송을 하는데, 이 때문에 VM Resource를 고정적으로 할당 할 수 밖에 없는 환경이지만, FTT1, FTT2 등 Object별로 개별 설정이 가능하다

> Client의 요구사항에 맞게 정책을 설정하여 Design한 구성을 운영하는게 모범 사례

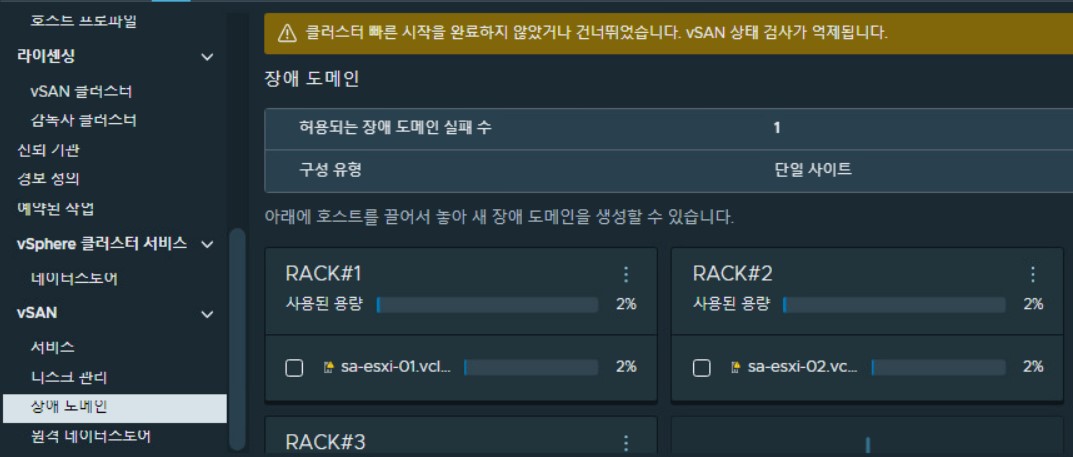

- Fault Domain (장애 도메인)

> Host별 RACK#1, #2, #3으로 구성

- Disk Management

> Disk Group

하나의 Disk Group은 한 개의 Cache만 사용 가능 / 하나의 Capacity는 5개 까지 사용 가능 / Capacity는 7개의 Disk가 사용 가능

ex) 서버 하나에 Disk 를 45개 장착한다 하면 Capacity는 5개만 장착 가능 함

고객에게 disk group 1ea만 사용시 성능, 가용성 부분에서 미리 사전안내등을 해야하며 disk group 2ea이상 사용 하는 것이 권고사항

> VM Storage Migration

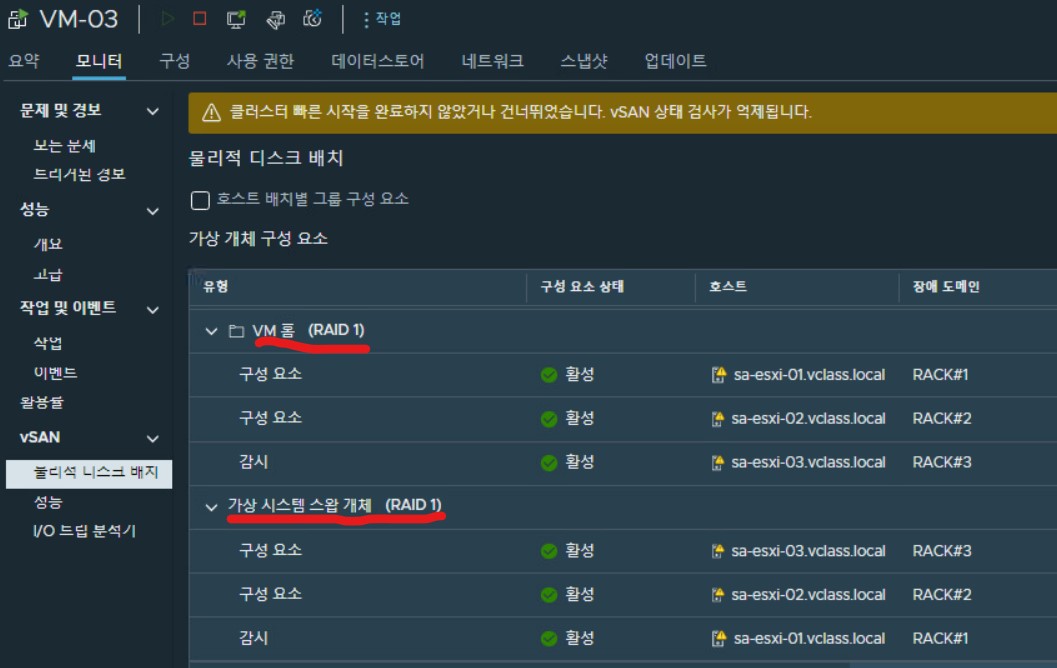

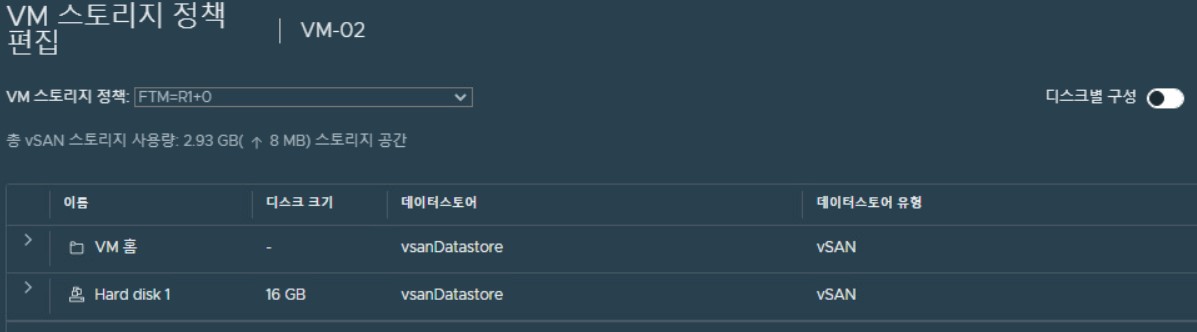

vSAN은 RAID 1로 항상 Mirroring해 실제 HDD가 10G라고 치면 할당은 20G로 보인다

> 고객 요구 사항중 가장 중요한것은 정책

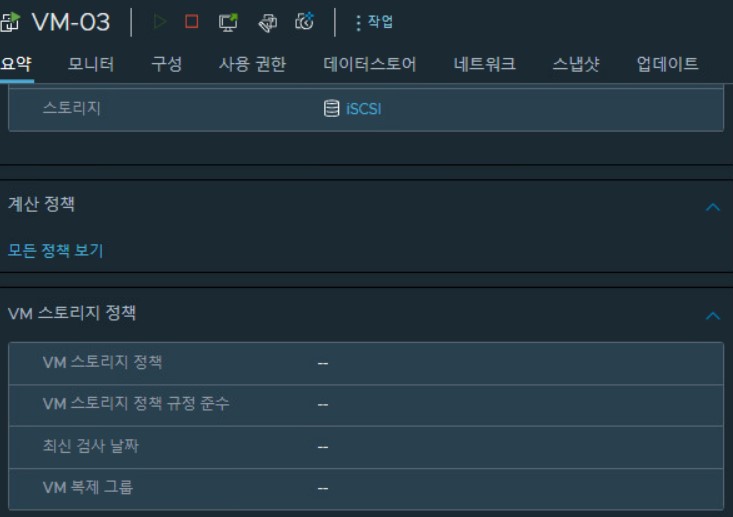

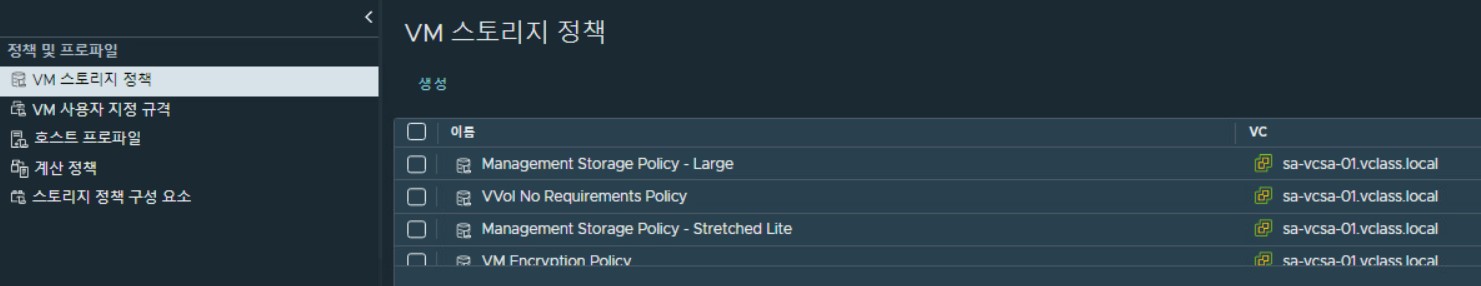

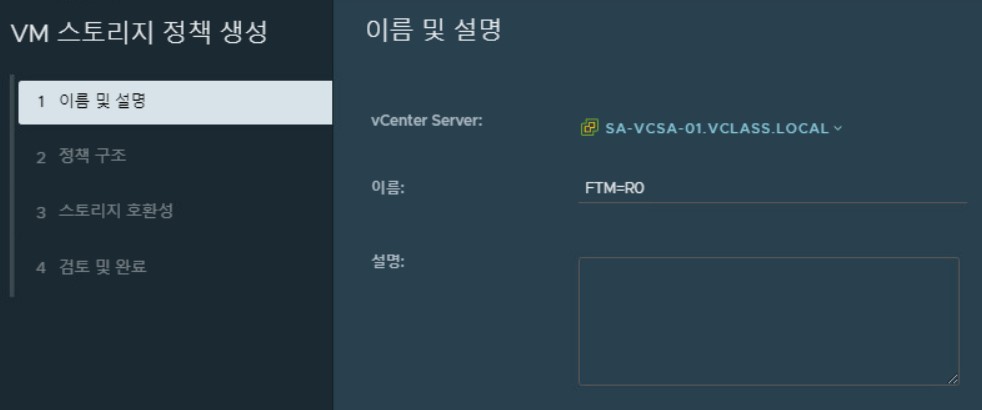

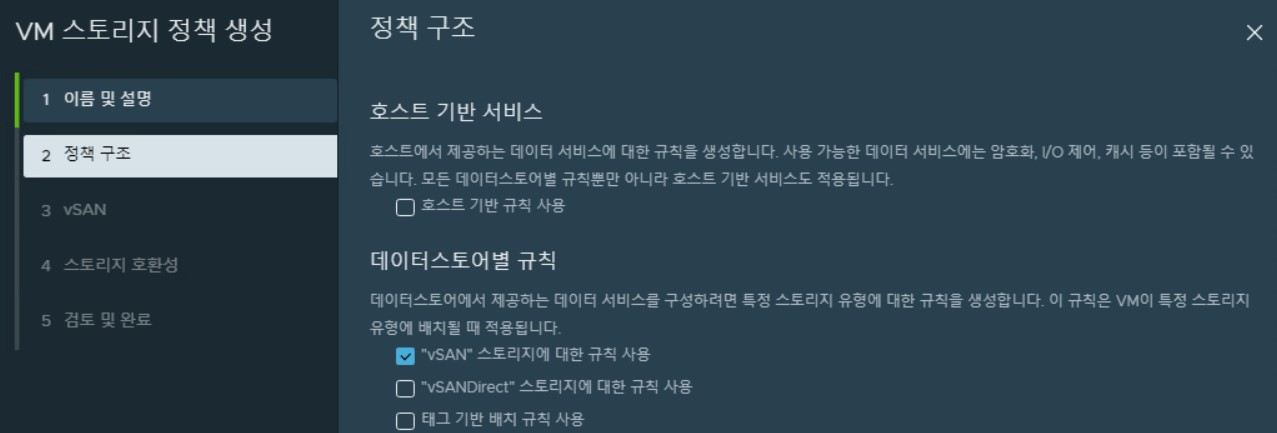

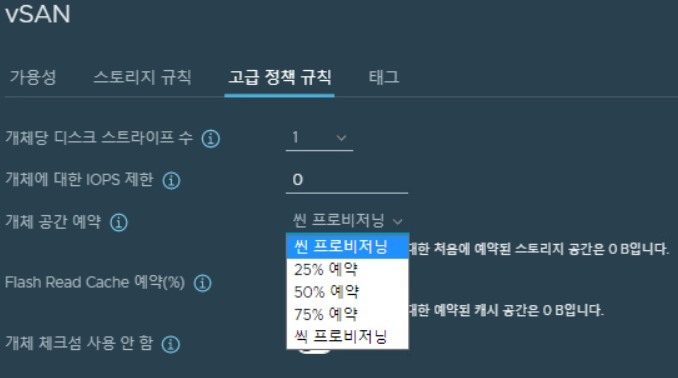

> VM Storage 정책을 구성해보도록 한다! ** vSAN Policy는 Default인 FTM mirroring FTT 1 정책 사용

FTM=R5 의 의미는 Parity 연산을 쓰고 하나의 장애를 감내합니다 라는 정의

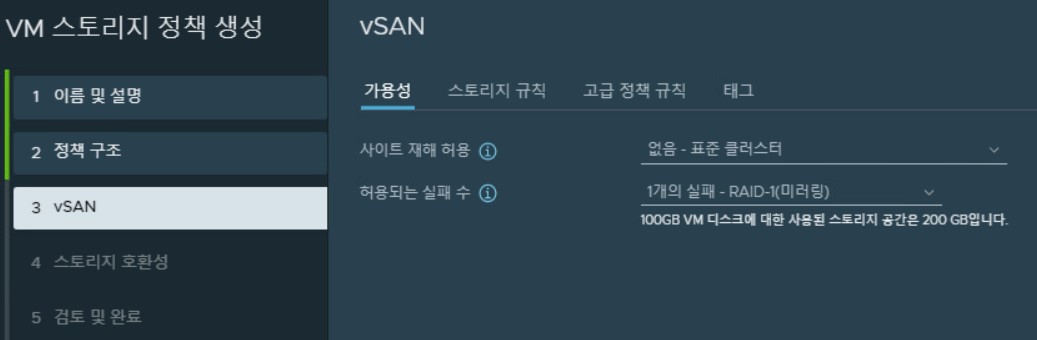

지금 하는 구성은 FTM=R1 FTT=1(1은 기본이고 숫자가 늘어나는 것은 Server의 가용 대수)

위 FTM=R1 FTT=1의 의미는 R1(Mirroring) 방식을 사용하고 FTT=1은 서버 한 대를 의미한다

> FTM=R0(FTT=0)

> 1개의 실패 - RAID-1(Mirroring)이 기본 설정이며 disk 단에서 100GB를 실제로 쓴다면, Mirroring 때문에, 200GB를 사용하게 되고 데이터 중복성 없음 을 사용하게 되면 실제 disk 할당량만 사용

> HDD는 Seek Time이 존재해 느린데 Spinning 을 줄이고자 Stripe 수를 늘려 이 Seek Time을 줄일 수 있는 효과 기대

Buffer = Write 기능 중 전부 한번에 가져와서 읽어 들이는 공간

Cache = 미리 읽어논 Data중 내가 읽을 부분을 가져오는 것을 말함

Read Cache = SSD는 Read할 때 시간이 걸릴 필요가 없는데, 이처럼 All-Flash 는 Read Cache가 없고 Buffer만 100 할당 됨

> Flash Read Cache Reservation : 꼭 필요한 Data만 찍어서 읽어 들이는 예약률(%)

> Disable object checksum (무결성) : vSAN storage의 성능을 높이고 싶으면 해당 내용은 Check 해제를 하는게 바람직

> Force Provisioning : "성능이고 나발이고 닥치고 해!"

> VM의 Disk IMage는 2T까지 할당 해줄 수 있다 , Capacity disk 도 이처럼 2T로 맞추어야 하는데, 권장은 이보다 낮추어 제시를 해줌

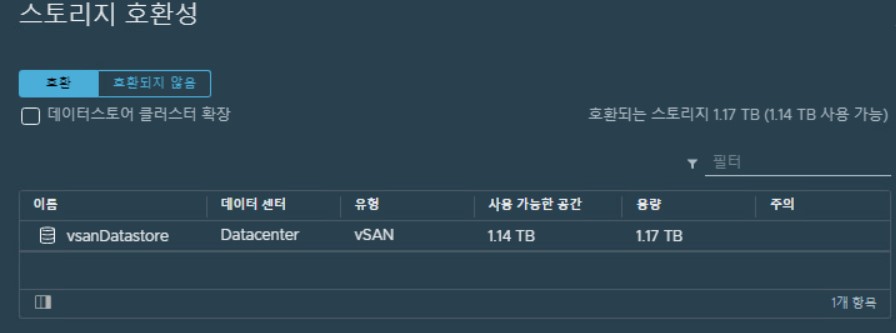

> Storage Compatibility : 우리가 만든 정책을 적용 가능한 datastore를 찾는 단계

> 위 같은 방법으로 R5, R1+0 정책을 추가로 생성함. FTM=R5의 경우 강제 프로비저닝을 사용하면 호환 가능한 DataStore가 보이게 되고, R1+0의 경우에는 Mirroring과 Stripe를 동시에 해야하기 때문에 고급 설정에서 Stripe 를 default 인 1 에서 2로 늘려주면 된다.

ㄴ 생성한 정책으로 VM에 적용

> FTM=R5 (서버 4대가 필요하기 때문에 정책 규정 준수는 비준수로 표기되고, 강제 프로비저닝을 옵션에 주었기 때문에 VM생성 및 실행은 가능하다(강제 프로비저닝을 옵션에 주지 않을 경우 VM생성 실패 하게됨)

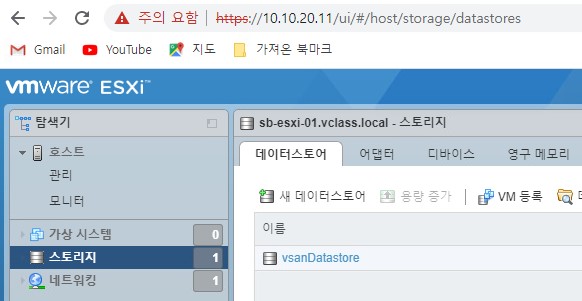

> ESXi Host 1에서 vSAN Object 들에 대한 정보 확인

[ vSphere ICM w. Ansible - Site B 구성 ]

Site B도 이전 Site A 구성과 마찬가지로 ESXi Server 3ea 및 기 생성된 분산 스위치에 분산 포트 그룹 및 업링크 매칭까지 완료 후 'Domain Name : sa-vcsa-01.vclass.local' 내 Cluster에 Host추가 진행

> Topology상 Site B는 별도의 분산가상스위치/분산 포트그룹 생성 포트그룹 별 VLAN도 Site A의 분산포트그룹과 상이한것 확인

> Host추가 시 Ansible로 실행한 .yml script에 중복되는 DataStore name이 있어 추가가 되지 않는 Issue 발생.

> 해당 ESXi Host Web GUI로 접속 후 DataStore를 삭제 후 Host추가 하면 정상 등록 >> Failure ESXi host VM삭제 후 재설치 진행

> Cluster내 Host등록시 유지보수모드(Maintenance mode)로 Host 추가가 되었는데, 이때 유지보수 모드 해제 후 Datastore 삭제시 해당 Host 연결 끊김 현상 발생 : 유지보수모드 유지 상태에서 DataStore 삭제

09-26일자에 이어 Trouble Shooting..

'가상화(VMware)' 카테고리의 다른 글

| [VMware] 09-27 Horizon(VDI) (0) | 2022.09.27 |

|---|---|

| [VMware] 09-26 vSAN(w. Ansible) (2) | 2022.09.26 |

| [VMware] 09-22 vCenter Server Cluster HA (2) | 2022.09.22 |

| [VMware] 09-21 vCenter Server (1) | 2022.09.21 |

| [VMware] 9-20 ESXi Storage(DataStore Mount) & VM & vCenter install (0) | 2022.09.20 |